| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- Sequence data

- 거리 기반 이상탐지

- SQL 데이터 분석 첫걸음

- multi modal

- Clustering 기반 이상탐지

- XAI

- Condensed neares neighbor rule

- Text generation

- 프로세스 마이닝

- Random Undersampling

- Data Imbalance

- Process Mining

- 밀도 기반 이상탐지

- 딥러닝

- PM4Py

- auto encoder

- Meta heuristic

- 병리 AI

- Digital Pathology

- Inatance segmentation

- OCSVM

- 국비지원교육

- Gausian Density Estimation

- Grad-CAM

- Petri net

- One-Sided Selection

- Fixed Learning

- Generative modeling

- Tomek links

- GAN

- Today

- Total

Create Opportunities

[인공지능 응용] eXplainable AI (PDP, ICE, LIME) 본문

설명 가능한 인공지능을 배운다.

The results of the solution can be understood by humans.

The process of generating human-understand explanations.

Understand the cause of a decision.

The process of giving explanations to humans.

왜 필요할까?

1. Help building trust :

2. Promote safety :

3. Allow for contestability

신뢰 / 안정성 보장 / Black box 모델은 Rule based도 아니고, 일련의 추론 과정을 설명하지 않기 때문

인공지능이 설명력을 갖춘다면, 뭘 어떻게 갖출건데?

1. Simulatability : 알고리즘의 각 단계를 하나씩 확인 가능 / Ex) Decision Tree

2. Algorithmic Transparency : 이해하기 쉬운 모델의 특성을 확인 가능 / Ex) SVM

eXplainable AI를 보통 XAI라고 부른다.

XAI는 모델을 만들기 전, 후, 그리고 도중에도 구축할 수 있다. 보통 After building a model. 즉, AI 모델 구축 후 이에 대한 설명력을 확인할 수 있도록 하는 XAI에 관심이 있다. 이러한 XAI는 아래와 같이 두 가지로 나누어 볼 수 있고, 또 우리는 보통 Post hoc에 해당하는 XAI에 관심을 가진다. 당연히 그렇지 않을까? 상대적으로 학습 능력이 좋은 모델들은 설명력이 떨어진다. 그만큼 복잡한 것이다. 그래서 XAI가 하고자 하는 것은 예측 성능도 좋은데, 설명력도 좋은 모델을 찾는 것이다.

Intrinsic은 기존에 설명력을 가지고 있는 Decision Tree와 같은 모델들을 대상으로 한다.

Post hoc은 그렇지 않은 딥러닝과 같은 Black box 모델을 대상으로 한다.

기존에 설명력을 가지는 학습 모델은 또 뭐가 있겠는가. 선형회귀가 대표적이겠고, Decision Tree, Random Forest가 있을 것이다. 이러한 학습 모델들은 설명 가능한 인공지능의 Surrogate한 모델들이다. 하지만 뭐라했지? 우리는 Black box 모델들을 열어보고 싶은 것이다.(Post hoc Interpretability)

Model Agnostic method

여기서 Agnostic이란, 어떤 모델인지 별로 중요하지 않다는 뜻이다.

어떤 모델이 들어와도 적용 가능한, XAI를 봐보자.

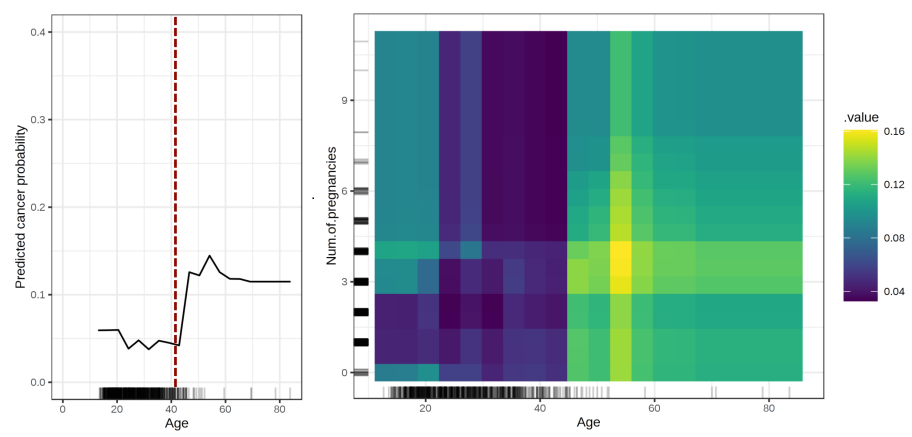

1) PDP

P(Xc) : Xc에 해당하는 변수가 어떤 값을 갖던간에, y에 대한 설명력이 존재하지 않도록 하는 것인데, Monte Carlo method를 통해 sampling한 확률값들을 모두 marginalization하는 것이다.

이러한 PDP는 결과적으로 아래의 예시와 같이 무척 직관적이다.

단점은 아래와 같다.

- 2개, 3개의 변수에 대한 설명력만 plotting할 수 있다.

- outlier에 민감하다.

- 변수들 간 독립성 가정이 필요하다.

- Xc 변수들을 Heterogeneous effects를 고려하기 어렵다.

2) ICE

- sample마다의 모든 영향도를 보여줄 수 있기 때문에 평균적인 영향도만 확인 가능한 PDP보다 더욱 직관적이다.

- Heterogeneous relation을 확인 가능하다. (= sample들의 영향력의 분산을 고려하여 확인 가능)

- 단점은 PDP와 동일하다.

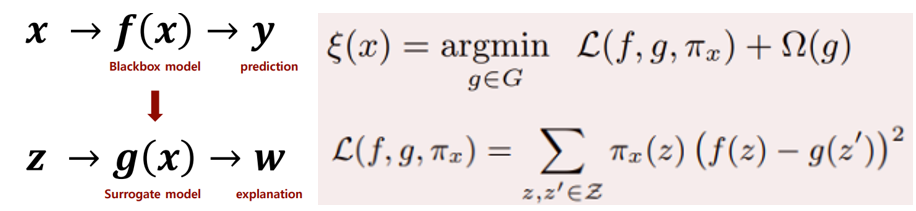

3) LIME (Local Interpretable Model-agnostic Expectations)

Black box 모델을 지역적으로 근사함으로써 설명 가능하며 Linear한 surrogate 모델을 구축하여 예측 모델을 설명하고자 한다.

Local : global이 아닌, locally한 부분에 대한 신뢰성에 대해서 설명하고자 한다.

Interpretable : 예측에 어떠한 변수가 사용되었는지에 대한 해석!

Model-agnostic : 어떤 모델이든!

Explanations : 사람이 이해할 수 있게!

Surrogate model이 LIME의 핵심이 되는 부분이라고 할 수 있겠다. 설명력이 높은 모델을 Surrogate Model로써 활용하여 단일 샘플에 대한 해석을 제공할 수 있다.

ㅠx : 각각의 변수에 대한 가중치를 의미한다.

Ω(g) : g가 복잡해지지 않도록 / 설명력을 유지하도록 하는 term

파트는 지역적인 scope에서의 좋은 Linear regression 모델을 적합하고자 작용하는 텀이고, 모델이 너무 복잡해져 해석이 어려워지는 것을 방지하고자 하는 정규화 term이라고 보면된다.

LIME의 단점

- Time consuming

- The discretization of the variables is needed

- It’s difficult perturb new data sufficiently to cover overall abnormal cases

전반적인 설명이 너무 잘되어 있습니다. 감사합니다.

https://moondol-ai.tistory.com/396

(Explainable AI) LIME 개념 이해하기

LIME이란? Local surrogate model(한국어로 굳이 번역하자면 "국소 대체 모델")은 블랙박스 머신러닝 모델의 개별 예측을 설명하는 데 쓰이는 해석 가능한(interpretable) 모델입니다. 여기서 잠깐! surrogate mo

moondol-ai.tistory.com

'인공지능' 카테고리의 다른 글

| Multi Modal ? (0) | 2023.03.07 |

|---|---|

| [인공지능 응용] eXplainable AI (SHAP) (0) | 2022.12.04 |

| Meta Heuristics ? (0) | 2022.12.03 |

| [인공지능 응용] 데이터 불균형 문제 (3) (0) | 2022.10.04 |

| [인공지능 응용] 데이터 불균형 문제 (2) (1) | 2022.09.20 |